Les 4 top outils de Web Scraping en 2025

Découvrez les meilleurs outils de web scraping de 2025, y compris Octoparse, ParseHub, Scrapy, et Diffbot , pour transformer efficacement vos données web.

Découvrez les meilleurs outils de web scraping de 2025, y compris Octoparse, ParseHub, Scrapy, et Diffbot , pour transformer efficacement vos données web.

À l'ère du Big Data, le web scraping est devenu un outil incontournable pour les entreprises cherchant à collecter et à analyser de grandes quantités de données en ligne. Que ce soit pour la veille concurrentielle, la gestion de la réputation en ligne, l'analyse de marché, ou le développement de l'intelligence artificielle, le scraping web permet de transformer des informations dispersées sur internet en données structurées et exploitable.

Dans cet article, nous explorerons les quatre meilleurs outils de web scraping en 2025, en évaluant leurs fonctionnalités, facilité d'utilisation et applications pratiques.

Octoparse est un outil de web scraping qui séduit par sa convivialité et son interface intuitive drag-and-drop. Destiné aussi bien aux non-programmeurs qu'aux développeurs expérimentés, Octoparse permet de récupérer des données de sites web complexes sans écrire une seule ligne de code.

ParseHub, grâce à ses technologies avancées de reconnaissance de texte et d'apprentissage automatique, est capable de naviguer et extraire des données de sites dynamiques où les données changent régulièrement. Il supporte également le JavaScript, AJAX, cookies, sessions, et redirige.

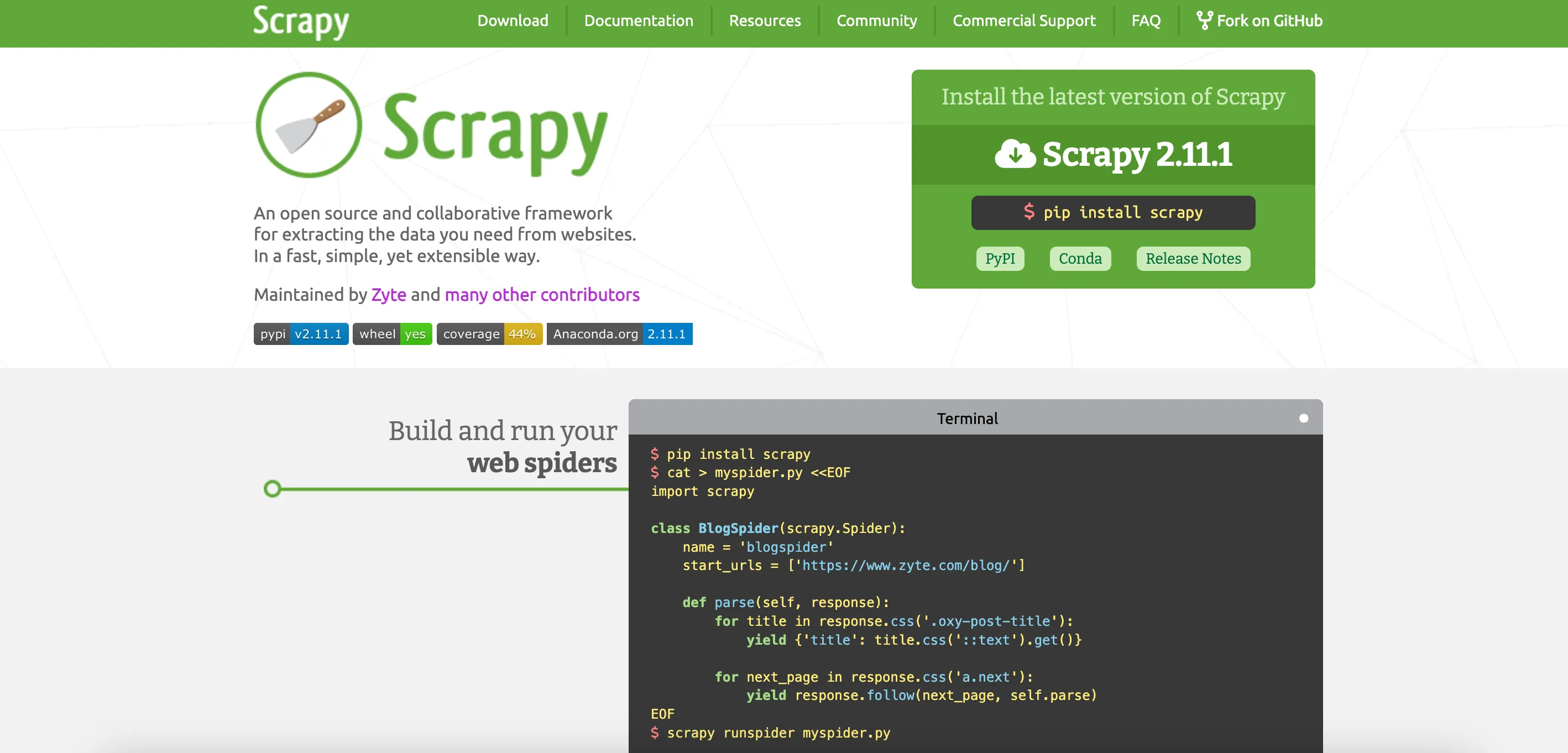

Scrapy est une framework open-source favorisé par les développeurs pour la création de spiders robustes et évolutifs. Utilisé par des start-ups comme par des multinationales, Scrapy est idéal pour les projets de scraping nécessitant une personnalisation élevée et des performances de haut niveau.

Diffbot est un outil d'extraction web basé sur l'intelligence artificielle qui se spécialise dans la transformation de pages web entières en données structurées. Utilisé par des entreprises de toutes tailles, Diffbot excelle particulièrement dans l'analyse de pages complexes grâce à son moteur de vision par ordinateur et son traitement du langage naturel.

Le web scraping est une compétence précieuse dans le toolkit numérique de toute entreprise moderne. Choisir l'outil adéquat dépend de vos besoins spécifiques en termes de complexité du projet, de volume de données et de compétences techniques. Les quatre outils présentés—Octoparse, ParseHub, Scrapy, et BeautifulSoup—offrent une gamme variée de fonctionnalités adaptées à divers scénarios d'utilisation. En 2025 exploiter ces outils peut vous fournir un avantage concurrentiel significatif en transformant les données non structurées du web en insights précieux pour votre entreprise.

Contactez nos experts pour des solutions innovantes et personnalisées

Tester la plateforme gratuitementNous contacter.svg)

15 jours d'essai

.svg)

Pas de carte de crédit

.svg)

Annulez à tout moment